0

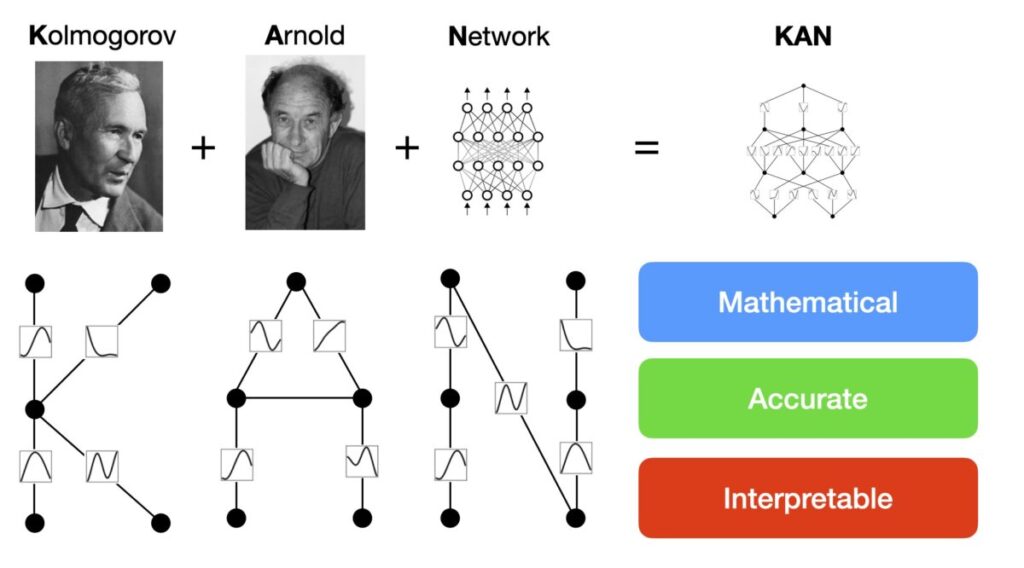

Дослідники з провідних американських інститутів презентували нову архітектуру нейронної мережі Kolmogorov-Arnold Networks (KAN). Вона стала альтернативою багатошаровим перцептронам (MLP) — принципом, розробленим ще 1957 року.

На відміну від перцептрону (MLP), що представляє спрощену модель біологічної нейронної мережі, де центр поставлена математична модель сприйняття інформації мозком, KAN заснована на глибоких математичних принципах. А саме – на апроксимаційній теоремі радянських математиків А. Н. Колмогорова та В. І. Арнольда, або теоремі суперпозиції.

Нейронна мережа Kolmogorov-Arnold Networks (KAN) / © Ziming Liu

Нейронна мережа Kolmogorov-Arnold Networks (KAN) / © Ziming Liu

Дослідники зазначили, що KAN, на відміну від MLP, може обробляти нову інформацію без катастрофічного забування. Модель постійно перебуває в актуальному стані, не покладаючись на будь-яку базу даних чи перенавчання.

KAN видає відповіді набагато краще і точніше звичних моделей, проте його навчання вимагає великих обчислювальних потужностей. Нова архітектура може відкрити можливості для подальшого вдосконалення глибокого навчання ШІ.